Prompt-最大程度榨干大模型

帮助大家学会使用prompt与人工智能对话

关于模型微调

2.1 大语言模型介绍大语言模型的概念大语言模型(英文:Large Language Model,缩写LLM),也称大型语言模型,是一种人工智能模型,旨在理解和生成人类语言。

通常,大语言模型 (LLM) 指包含数十亿(Billion或更多)参数的语言模型,这些模型在大量的文本数据上进行训练,例如国外的有GPT-3 、GPT-4、PaLM 、Galactica 和 LLaMA 等,国内的有ChatGLM、文心一言、通义千问、讯飞星火等。

大模型的能力和特点

大模型的能力

大语言模型(LLM)与以前的预训练语言模型(PLM)的主要区别在于其涌现能力。这种能力在小型模型中不明显,但在大型模型中显著。例如:

上下文学习:首次由GPT-3引入,允许模型在提供自然语言指令或多个任务示例的情况下,通过理解上下文并生成相应输出来执行任务。

指令遵循:通过指令微调,LLM可以根据任务指令执行未见过的任务,展示出强大的泛化能力。

逐步推理:通过”思维链(Chain of Thought, CoT)“策略,LLM能够解决多步推理任务,例如数学问题。

大模型的特点

巨大的规模:参数规模达数 ...

基于Transformer解决机器翻译任务

一、Transformer 介绍基于循环或卷积神经网络的序列到序列建模方法是现存机器翻译任务中的经典方法。然而,它们在建模文本长程依赖方面都存在一定的局限性。

对于卷积神经网络来说,受限的上下文窗口在建模长文本方面天然地存在不足。如果要对长距离依赖进行描述,需要多层卷积操作,而且不同层之间信息传递也可能有损失,这些都限制了模型的能力。

而对于循环神经网络来说,上下文的语义依赖是通过维护循环单元中的隐状态实现的。在编码过程中,每一个时间步的输入建模都涉及到对隐藏状态的修改。随着序列长度的增加,编码在隐藏状态中的序列早期的上下文信息被逐渐遗忘。尽管注意力机制的引入在一定程度上缓解了这个问题,但循环网络在编码效率方面仍存在很大的不足之处。由于编码端和解码端的每一个时间步的隐藏状态都依赖于前一时间步的计算结果,这就造成了在训练和推断阶段的低效。

为了更好地描述文字序列,谷歌的研究人员在 2017 年提出了一种新的模型 Transformer,学有余力的同学可以阅读一下原论文《Attention Is All You Need》,也可以直接看李沐老师的B站讲解:Transformer论 ...

NLP入门

Datawhale夏令营第二期

超算简介

什么是超级计算?

hexo框架原理

关于hexo框架搭建前沿知识博客的原理介绍

Web3介绍

An introduction to Web3—the next evolution of the World Wide Web—and why it matters

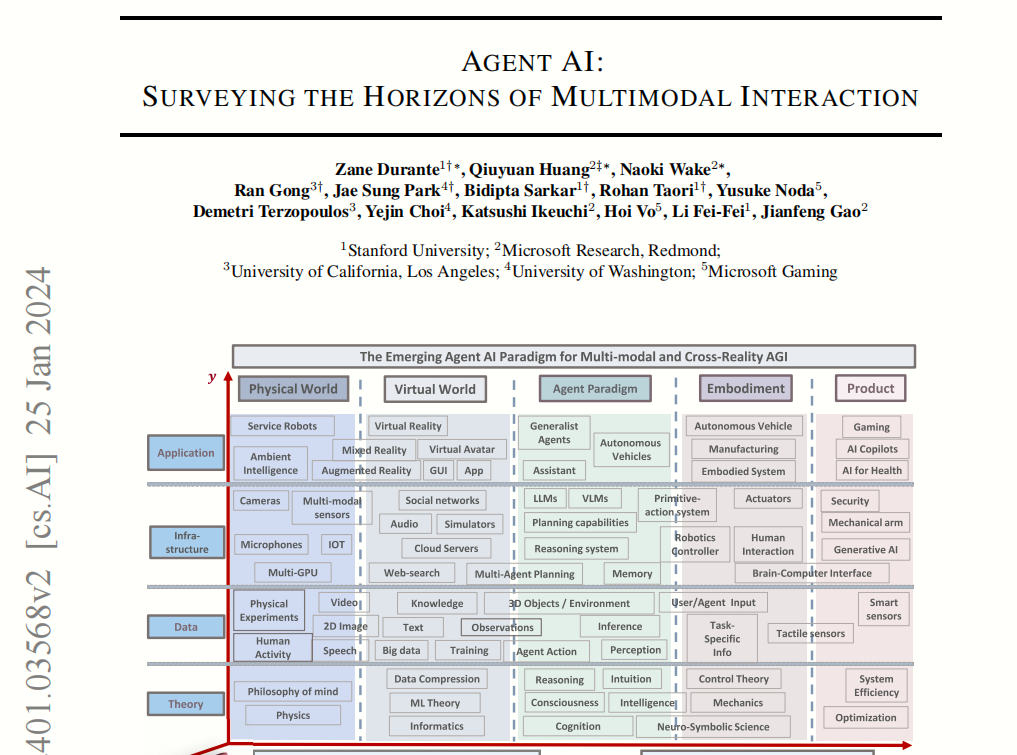

自然语言处理NLP

NLP发展历程