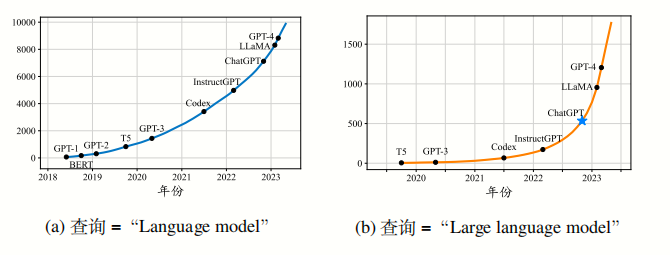

大模型发展历程

大语言模型发展与应用全景解析

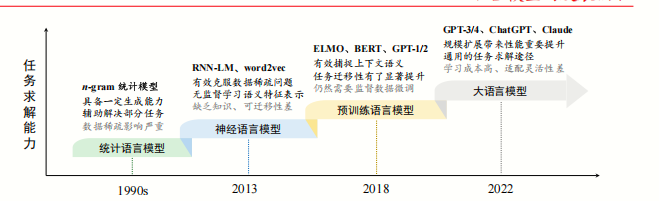

语言模型发展历程

早期统计语言模型(1950s-2000s)

- 规则系统探索

1966年MIT开发的首个聊天机器人ELIZA采用模式匹配规则1,1970年代SHRDLU系统展示早期语义理解能力,但依赖人工规则编写1。 - 统计方法兴起

1990年代n-gram模型通过计算n元词组联合概率预测文本,隐马尔可夫模型(HMM)推动语音识别发展2。此时模型受限于语料库规模(通常仅百万级)和长距离依赖捕捉能力3。

统计语言模型(Statistical Language Model, SLM). 在 20 世纪 90 年代兴起的统计语言模型 [4, 5] 是基于统计学习方法研发的。具体来说,统计语言模型使用马尔可夫假设(Markov Assumption)来建立语言序列的预测模型,通常是根据词序列中若干个连续的上下文单词来预测下一个词的出现概率,即根据一个固定长度的前缀来预测目标单词。具有固定上下文长度 𝑛 的统计语言模型通常被称为 𝑛 元(𝑛-gram)语言模型,如二元或三元语言模型。统计语言模型被广泛应用于信息检索

(Information Retrieval, IR)和自然语言处理(Natural Language Processing, NLP)等领域的早期研究工作。对于高阶统计语言模型来说,随着阶数 𝑛 的增加,需要估计的转移概率项数将会指数级增长,经常会受到“维数灾难”(Curse of Dimensionality)的困扰。为了缓解数据稀疏问题,需要设计专门的语言模型平滑策略,如回退估计(Back-off Estimation)和古德-图灵估计(Good-Turing Estimation)。然而平滑方法对于高阶上下文的刻画能力仍然较弱,无法精确建模复杂的高阶语义关系。

神经网络语言模型(2010-2017)

- 词向量革命

Google 2013年提出Word2Vec,通过Skip-gram/CBOW算法实现语义向量化,突破传统词袋模型局限2,4。 - 序列模型演进

LSTM(1997提出,2010s普及)解决RNN梯度消失问题,支持200+词距记忆1;2015年Seq2Seq架构推动机器翻译突破2。

神经语言模型(Neural Language Model, NLM). 神经语言模型 [6, 7] 使用神经网络来建模文本序列的生成,如循环神经网络(Recurrent Neural Networks, RNN)。图1.1 语言模型的发展历程灵奖获得者 Yoshua Bengio 在一项早期工作中 [6] 引入了分布式词表示(DistributedWordRepresentation)这一概念,并构建了基于聚合上下文特征(即分布式词向量)的目标词预测函数。分布式词表示使用低维稠密向量来表示词汇的语义,这与基于词典空间的稀疏词向量表示(One-Hot Representation)有着本质的不同,能够刻画更为丰富的隐含语义特征。同时,稠密向量的非零表征对于复杂语言模型的搭建非常友好,能够有效克服统计语言模型中的数据稀疏问题。分布式词向量又称为“词嵌入”(Word Embedding)。这种基于隐含语义特征表示的语言建模方法为自然语言处理任务提供了一种较为通用的解决途径。在这一系列工作中,word2vec [8,9] 是一个具有代表性的词嵌入学习模型,它构建了一个简化的浅层神经网络来学习分布式词表示,所学习到的词嵌入可以用作后续任务的语义特征提取器,在自然语言处理任务中得到了广泛使用,取得了显著的性能提升。这些创新性的研究工作将语言模型用于文本表示学习(超越了原始的词序列建模目标),在自然语言

处理领域产生了重要影响。

Transformer与预训练模型(2017-2019)

- 架构革命

2017年Transformer通过多头自注意力机制实现全局依赖捕捉,训练速度比LSTM快10倍4,9。BERT(2018)采用掩码语言模型(MLM)实现双向理解,GLUE基准分数提升7%-15%1,3。 - 预训练范式确立

GPT-1(2018)首次验证自回归预训练有效性,T5(2019)统一NLP任务为text-to-text框架3,6。

且不容易并行训练,这些缺点限制了早期预训练模型(如 ELMo)的性能。在 2017年,谷歌提出了基于自注意力机制(Self-Attention)的 Transformer 模型 [12],通过自注意力机制建模长程序列关系。Transformer 的一个主要优势就是其模型设计对于硬件非常友好,可以通过 GPU 或者 TPU 进行加速训练,这为研发大语言模型提供了可并行优化的神经网络架构。基于 Transformer 架构,谷歌进一步提出了预训练语言模型 BERT [13],采用了仅有编码器的 Transformer 架构,并通过在大规模

无标注数据上使用专门设计的预训练任务来学习双向语言模型。在同期,OpenAI也迅速采纳了 Transformer 架构,将其用于 GPT-1 [14] 的训练。与 BERT 模型不同的是,GPT-1 采用了仅有解码器的 Transformer 架构,以及基于下一个词元预测的预训练任务进行模型的训练。一般来说,编码器架构被认为更适合去解决自然语言理解任务(如完形填空等),而解码器架构更适合解决自然语言生成任务(如文本摘要等)。以 ELMo、BERT、GPT-1 为代表的预训练语言模型确立了“预训练-微

调”这一任务求解范式。其中,预训练阶段旨在通过大规模无标注文本建立模型的基础能力,而微调阶段则使用有标注数据对于模型进行特定任务的适配,从而更好地解决下游的自然语言处理任务。

大语言模型时代(2020-至今)

规模跃迁

GPT-3(2020)达1750亿参数,零样本任务准确率较GPT-2提升40%5;PaLM(2022)5400亿参数实现复杂数学推理12。能力涌现

GPT-4(2023)在Bar考试中超越90%人类考生,DeepSeek-R1(2025)支持128K上下文窗口和671B参数4,6。开源生态

LLaMA(2023)、ChatGLM(清华)等模型推动技术民主化,Qwen2.5支持1M token超长文本处理6,10。具有较为丰富的世界知识: 与传统机器学习模型相比,大语言模型经过超大

规模文本数据的预训练后能够学习到较为丰富的世界知识。具有较强的通用任务解决能力 :大语言模型第二个代表性的能力特点是具有

较强的通用任务求解能力。具有较好的复杂任务推理能力. 除了具有通用性外,大语言模型在复杂任务

中还展现出了较好的推理能力。具有较强的人类指令遵循能力: 大语言模型建立了自然语言形式的统一任务

解决模式:任务输入与执行结果均通过自然语言进行表达。具有较好的人类对齐能力. 机器学习模型的安全性一直以来是一个重要的研

究课题。具有可拓展的工具使用能力:在机器学习领域,模型的设计和实现往往都具

有一定的局限性,例如会受到所采用的归纳假设以及训练数据的限制。

规模文本数据的预训练后能够学习到较为丰富的世界知识。

大语言模型核心特点

超大规模参数体系

训练范式创新

泛化与涌现能力

多模态扩展

关键技术突破

Transformer架构创新

训练优化技术

对齐与安全

- RLHF技术:Proximal Policy Optimization(PPO)算法平衡多样性与安全性5,12

- Constitutional AI:通过AI监督实现价值观对齐,有害输出率降低10倍13